La critique de Fodor : Localiser n’est pas expliquer. Jerry Fodor pose une question dérangeante : pourquoi cette fascination pour la localisation des fonctions mentales dans le cerveau ? Les techniques d’imagerie cérébrale nous révèlent où et quand certaines régions s’activent durant des tâches cognitives spécifiques. Un secteur s’illumine quand on pense aux théières, un autre quand on entend des noms plutôt que des verbes, un autre encore quand on voit des légumes. Mais quelle connaissance gagnons-nous vraiment ?

L’argument central de Fodor est simple mais dévastateur : savoir où se produit une fonction ne nous dit rien sur comment elle se réalise. Son analogie avec le carburateur est parlante. Comprendre le fonctionnement d’un moteur exige de saisir que le carburateur aère l’essence, qu’il contribue ainsi au fonctionnement global. Mais pourquoi importe-t-il de savoir où exactement le carburateur se situe dans le moteur ? À moins de vouloir le retirer chirurgicalement, cette information topographique n’ajoute rien à la compréhension du mécanisme.

De même pour le cerveau. Personne ne doute sérieusement que parler, faire du vélo ou construire un pont dépend de processus cérébraux quelque part au nord du cou. Mais pourquoi préciser à quel point au nord ? Fodor souligne que les neuroscientifiques accumulent des cartes cérébrales sans hypothèses claires sur ce qu’elles sont censées nous révéler. Ce sont des scientifiques « qui ont une caméra mais pas d’hypothèse ».

La corrélation entre activité neuronale et fonction mentale ne constitue pas une explication causale du fonctionnement. Elle nous dit « quand » et « où », mais reste muette sur le « comment » et le « pourquoi ». Cette critique méthodologique est redoutable : si la recherche la plus coûteuse en neurosciences se contente de localiser sans expliquer, elle absorbe des ressources qui pourraient servir à élucider les mécanismes réels. (Attention : Fodor ne conteste aucunement la valeur de la localisation à la neurologie ou à la neuropsychologie cliniques.)

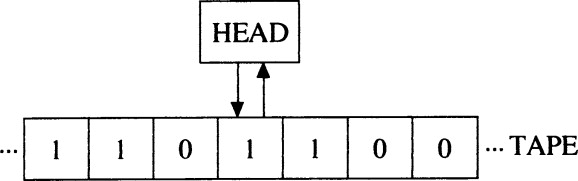

Les neurones miroirs : Un cas d’école apparent. La découverte de Rizzolatti des neurones miroirs semble, à première vue, illustrer parfaitement la critique de Fodor. Ces neurones dans le cortex précentral ventral du macaque s’activent aussi bien quand le singe exécute une action (saisir un objet) que lorsqu’il observe un autre individu exécuter la même action. Des neurones aux propriétés similaires ont été localisés dans le lobule pariétal inférieur. Chez l’humain, les données d’EEG, MEG, TMS et d’imagerie (TEP, IRMf) confirment l’existence d’un système miroir.

Pendant des années, cette découverte semblait offrir peu plus qu’une cartographie sophistiquée : voici où se produit l’activité miroir, voici quand elle s’active. L’imitation est une capacité comportementale que nous savions déjà posséder, partagée avec de nombreuses espèces, opérant dans plusieurs modalités sensorielles et motrices. Mais identifier les corrélats neuronaux de cette capacité ne révélait pas comment le cerveau la réalise. Aucun message utile pour les roboticiens cherchant à rétro-ingénierier cette réciprocité entre la perception sensorielle et la production motrice. Ce nr sont que des paramètres de localisation spatiotemporelle pour une fonction qui est déjà connue. Cette lecture initiale inscrivait les neurones miroirs dans le paradigme que critique Fodor : beaucoup de technologie coûteuse pour localiser ce que nous savions déjà exister, sans avancer d’un pas vers la compréhension mécanistique.

Le tournant : De la localisation à l’architecture. Mais cette lecture était trop rapide. Ce qui est important n’est pas la localisation d’un type de neurone en un lieu précis, mais la découverte d’un pattern systématique : la fonction miroir se révèle être omniprésent, multimodal, et architecturalement canonique.

Rizzolatti montre que les neurones miroirs ne se contentent pas de coder des actes moteurs isolés. Certains sont « contraints par l’action » : ils ne s’activent que si l’acte moteur observé s’inscrit dans une action spécifique. Un neurone peut décharger pour « saisir-pour-manger » mais pas pour « saisir-pour-placer ». Cette spécificité permet à l’observateur non seulement de reconnaître l’acte moteur observé, mais aussi de coder ce que sera le prochain acte moteur, donc de comprendre l’intention de l’agent.

Au-delà de l’action motrice, le mécanisme miroir opère aussi pour les émotions. L’insula antérieure et le cortex cingulaire antérieur s’activent à la fois quand un sujet éprouve du dégoût directement (exposition à des odeurs répugnantes) et quand il observe l’expression faciale du dégoût chez autrui. Des résultats similaires émergent pour la douleur. Le mécanisme miroir constitue ainsi la base neuronale de l’empathie.

Ce qui importe n’est donc pas qu’il existe un « module du dégoût » localisé dans l’insula, mais que la même structure qui élabore nos propres réponses émotionnelles s’active lors de l’observation des émotions d’autrui. Le pattern révèle un principe architectural : la compréhension d’autrui procède par transcription dans nos propres systèmes moteurs et émotionnels.

Transcription sensori-motrice. Rizzolatti souligne un point crucial : l’observation visuelle seule, sans implication du système moteur, ne fournit qu’une description des aspects visibles du mouvement. Elle n’informe pas sur ce que signifie réellement cette action. Cette information ne peut être obtenue que si la forme de l’action observée est aussi codée dans le système moteur de l’observateur. L’activation du circuit miroir devient ainsi essentielle pour donner à l’observateur une compréhension réelle, expérientielle de la production de l’action perçue.

Voilà ce qui échappe à la critique de Fodor appliquée mécaniquement. Il ne s’agit pas simplement de savoir où se trouve un module d’imitation, mais de reconnaitre que l’apparence perceptive chez autrui est conforme avec sa production chez soi-même. Le mécanisme miroir relie le codage de ce que ça fait de voir l’action par les aires visuelles complexes, vers les aires motrices qui codent ce que ça fait de faire cette action. Ce n’est pas une simple corrélation topographique, c’est un principe fonctionnel : comprendre l’action d’autrui, c’est savoir comment (et pourquoi) la produire soi-même.

Implications pour les origines du langage. Le mécanisme miroir offre un cadre pour aborder les origines gestuelles de la parole (qui seront traitées dans les semaines 6 à 8). Depuis Condillac, plusieurs auteurs ont suggéré que la voie menant à la parole est née des communications gestuelles et non des cris des animaux. Les neurones miroirs créent un lien direct entre l’émetteur du message et le receveur. Grâce au mécanisme miroir, les actions exécutées par un sujet deviennent des messages compris par un observateur sans médiation cognitive.

L’observation d’un sujet saisissant une pomme est immédiatement comprise puisqu’elle évoque le même codage moteur dans le système miroir de l’observateur. Rizzolatti et Arbib ont proposé que le mécanisme miroir soit le système basique à partir duquel a évolué le langage. Le mécanisme miroir aurait résolu deux problèmes fondamentaux de la communication : la parité (ce qui compte pour l’émetteur compte aussi pour le receveur) et la compréhension directe (aucun symbole arbitraire n’est nécessaire).

Évidemment, le mécanisme miroir n’explique pas à lui seul l’extrême complexité de la parole. Mais il aide à résoudre une difficulté fondamentale : comment un message valable pour l’émetteur le devient également pour le receveur. La réciptocit.sensori-moteur fournit une base pré-linguistique pour la communication intentionnelle.

De la simple localisation au pattern architectural. La portée des neurones miroirs dépasse donc largement la simple localisation d’une fonction dans le cortex prémoteur ventral. Ce qui compte, c’est le pattern : la capacité de mirroring est omniprésente (motrice, émotionnelle), multimodale (vision-action, son-action, émotion-expression), et distribuée à travers plusieurs régions interconnectées (cortex prémoteur, lobule pariétal, insula, cortex cingulaire).

Ce pattern révèle quelque chose d’architectural sur l’organisation fonctionnelle du cerveau : la compréhension d’autrui, qu’elle soit motrice, émotionnelle ou communicative, procède par transcription dans les systèmes propres de l’observateur. Cette transcription n’est pas une simple « copie » passive, mais aussi une activation ressentie qui permet la compréhension.

Fodor a raison : savoir où se trouvent les neurones miroirs ne constitue pas en soi une explication. Mais le pattern systématique de leur distribution multimodale et de leur fonctionnement révèle un principe architectural : la perception et la production sont intimement couplées, la compréhension passe par la réciprocité sensori-motrice.

L’imitation et l’apprentissage. Rizzolatti distingue deux aspects de l’imitation : la capacité de reproduire immédiatement une action observée, et celle d’apprendre une nouvelle action par observation. La répétition immédiate est assurée par le système miroir seul. Mais l’apprentissage par imitation exige l’intervention du lobe préfrontal, qui combine des actes moteurs élémentaires codés par le système miroir pour produire des configurations motrices nouvelles.

Cette distinction est cruciale. Le système miroir fournit les « copies motrices » d’actions observées, mais la composition de nouvelles séquences motrices requiert des mécanismes combinatoires préfrontaux supplémentaires. Encore une fois, ce n’est pas la localisation qui importe, mais la compréhension que différents niveaux de capacités imitatives recrutent différentes architectures neuronales en interaction.

Implications cliniques et évolutives.

Les données montrent que les enfants autistes ont un déficit dans leur système miroir, et que la sévérité de leur affection corrèle avec l’importance de ce déficit. Ceci suggère que le système miroir joue un rôle dans les capacités sociales fondamentales, notamment la compréhension d’autrui et la communication.

D’un point de vue évolutif, on peut voir le mécanisme miroir comme une solution au problème de la communication interindividuelle et de la cognition sociale. L’évolution darwinienne – le « Blind Watchmaker » – a résolu le problème de l’implémentation de cette capacité. Mais identifier ce que l’évolution a construit ne dispense pas les sciences cognitives de leur tâche : la rétro-ingénierie de cette capacité. Comprendre comment le cerveau réalise le réciprocité perception-production reste un défi ouvert.

Conclusion : Au-delà de Fodor. La critique de Fodor garde toute sa force contre une neuroscience qui se contenterait de cartographier sans théoriser. Savoir où et quand certaines régions s’activent ne suffit pas. Mais lorsque les données de localisation révèlent un pattern systématique – la distribution multimodale et fonctionnellement cohérente du mécanisme miroir – elles contraignent nos théories sur l’architecture fonctionnelle.

Les neurones miroirs ne sont pas intéressants parce qu’ils sont dans le cortex prémoteur plutôt qu’ailleurs. Ils sont intéressants parce que leur pattern de distribution révèle un principe : la compréhension sensori-motrice, émotionnelle et communicative d’autrui procède par transcription dans nos propres systèmes. Cette transcription constitue le substrat expérientiel de la compréhension.

La question n’est plus « où sont les neurones miroirs ? » mais « comment le cerveau implémente-t-il cette capacité de mirroring multimodale ? » Voilà une question que même Fodor pourrait peut-être juger digne d’investigation. Elle ne demande pas simplement une caméra, mais une hypothèse sur le mécanisme qui permet à la perception de se transcrire en représentation motrice, réciproquement et d’ainsi fonder la compréhension.

L’évolution a résolu le problème de l’implémentation. Aux sciences cognitives de faire leur travail de rétro-ingénierie.

Post-scriptum : La critique de Fodor à propos de la neuro-imagerie et de la localisation ne concerne pas seulement le phénomène des neurones miroirs lui-même, mais aussi le fait que la neuro-imagerie permet de poursuivre l’étude des capacités miroirs chez l’humain de manière inoffensive, plutôt que par des expériences invasives et cruelles sur les singes. La neuro-imagerie rend ce remplacement possible aussi dans beaucoup d’autres domaines de recherche neuroscientifique qui causent la souffrance aux animaux non humains.